關於 GA4 我只是略懂:Landing page report

從這一篇文章開始,我們將持續的分享 SEO 以及網站流量分析的系列文章,這不僅支持我們的 SEO 和 內容策略,也是我們 GenAI Ops 中關鍵數據的來源。透過這些分析,我們旨在改善與消費者的溝通,並體現我們對開放組織文化的承諾。

從這一篇文章開始,我們將持續的分享 SEO 以及網站流量分析的系列文章,這不僅支持我們的 SEO 和 內容策略,也是我們 GenAI Ops 中關鍵數據的來源。透過這些分析,我們旨在改善與消費者的溝通,並體現我們對開放組織文化的承諾。

Llama 2 官方文件中的提示工程建議:從明確指示到角色提示,再到自我一致性與檢索增強,讓略懂的我為你揭示如何精進提示詞工程進而提升 LLM 的推論品質。

在這篇文章中簡單的分享一下我如何嘗試在 Mac 上建立一個穩定的本地 Python 測試環境。從安裝 Python 和必要的工具,到配置 #虛擬環境 和 #測試框架,當然!我的開發環境配置絕對不是完美無瑕的,但是一個不斷迭代的過程的開始,一個不斷探索最適配我們自家組織商業發展過程的開發環境探索。

ReAct prompt pattern 是一種結合推理和行動的框架,用於增強 LLM 推論結果的品質。此技術讓模型在產生推理過程的同時,執行特定任務,包括與外部資源如知識庫互動。ReAct 結合了 Chain-of-Thought 的優勢,在知識密集型任務和決策任務中表現出色,提升了模型的可解釋性和可靠性。它通過動態推理來維持和調整行動計劃,並在推理過程中整合外部信息提升生成內容的即時性。

目前因為不明原因,以下這一段被許多人認為是 OpenAI bug 的提示詞到目前為止依舊可以讓 ChatGPT、Bing Chat 以及 GPTs 回傳 system prompt 或是 default instruction,只要在對話的最開始輸入並送出,ChatGPT 就會回傳當下對話 session 所使用的 instructions,但不得不說透過閱讀這些非常用心撰寫的 instructions 確實是可以學到很多有用的技巧。

基本上,在 AWS 上要能夠成功執行起 Llama 2 Chat (7B) #7B而已呦不是70B呦 的 Hello World 沒開個 g5.4xlarge 是跑不起來的,一個月不關機器採用 on-demand 的話要燒掉 37,968.84 TWD,反之用 AWS 的 Bedrock 你開個 Llama 2 Chat(70B)每

我實驗環境是部署在 GCP 上,Compute Engine 選用的 GPU 是 NVIDIA T4 1 x GPU,登入主機後第一件事當是是要先確定你啟用的 Instance 真的有 GPU 沒出意外的話,CLI 上會顯示 再來就是要確保你的主機有安裝好 CUDA,這邊基本上就是按照 Nvidia 官網上的教學一步一步的完成安裝 CUDA Toolkit 12.3 Update

Seamless 筆者一句話以概之:#翻譯蒟蒻 結案! Meta 提出的 Seamless model 能夠實現 end-to-end 的表達性多語言翻譯,並支持串流的處理方式。其中一項重要貢獻是改進後的 SeamlessM4T v2 模型,該模型基於更新的 #UnitY2 框架,並增加了對低資源(low-resource)語言的訓練。#SeamlessAlign 的擴展增加了大量自動對齊數據,支持高達 76 種語言。 模型的關鍵特性 性能評估 這裡的「適應性協議(Adapted Protocols)」可能包括以下幾個方面 理論上 Meta 透過這些適應性協議進行的人類評估,有助於更全面地理解和改進這些先進的自動語音翻譯系統,確保它們不僅在技術層面上先進,也在實際使用中達到人類使用者的期望和需求。

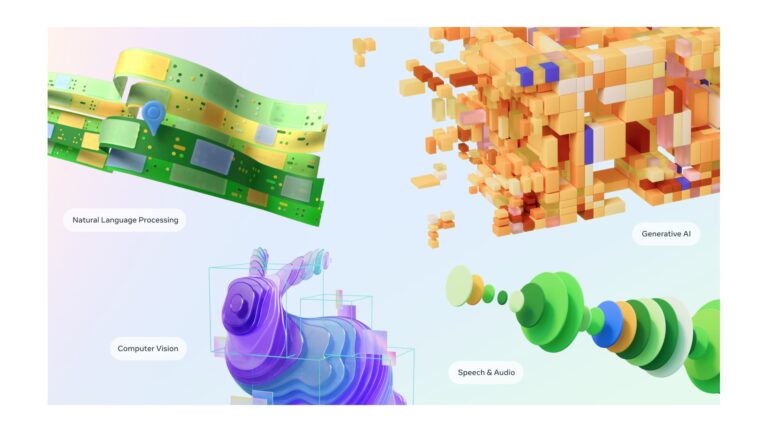

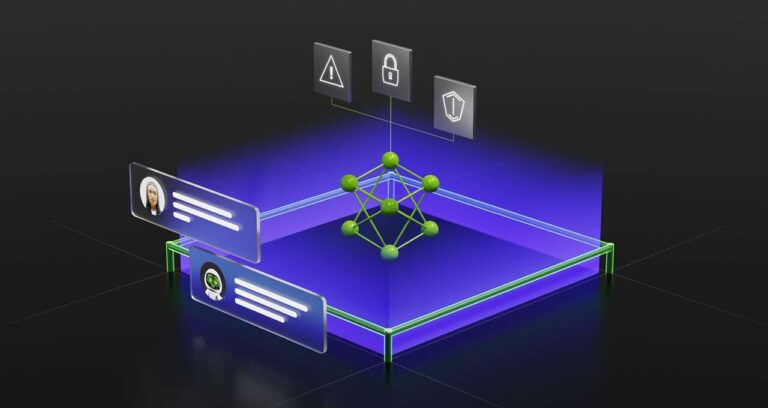

在去年十一月 ChatGPT 出現在我眼前之後,第一個想法就是 LLMs 勢必將會快速的掃除 Chatbot 這樣一個應用領域在過去遇到的許多問題,毫無意外的,聊天機器人現在嚴然是最多開發者實踐 LLMs 的 downstream task。根據 Gartner 的一些報告,他們預期到 2027 年,聊天機器人將成為所有組織中 25% 的主要溝通渠道。 這種採用速度相當驚人,但也存在危險。聊天機器人可以非常有說服力地杜撰事實,而要像對真人一樣給聊天機器人設置指引也更加的困難。所以,如果你客服渠道後面部署了一群真人客服,他們會受過關於如何談論你的公司、不該說什麼、應該說什麼以及要禮貌等各方面的培訓。但對於 LLM-based 的聊天機器人來說在實務上是一件相當困難的事情,實作過你就會清楚的知道開發出一個 ChatGPT 的體驗跟直接與 OpenAI 的 API