略懂 DeepSeek 模型的數據精度格式與混合精度訓練策略

DeepSeek 模型採用創新的混合精度訓練策略,靈活運用 FP8、BF16、FP32 等不同精度格式。其核心技術包括精度解耦、自動縮放、細粒度量化和遞增累加精度等方法,在保持模型穩定性同時大幅降低算力成本。這套策略讓 DeepSeek-V2 預訓練成本僅需 557.6 萬美元,遠低於同級模型,同時維持優異性能表現。

DeepSeek 模型採用創新的混合精度訓練策略,靈活運用 FP8、BF16、FP32 等不同精度格式。其核心技術包括精度解耦、自動縮放、細粒度量化和遞增累加精度等方法,在保持模型穩定性同時大幅降低算力成本。這套策略讓 DeepSeek-V2 預訓練成本僅需 557.6 萬美元,遠低於同級模型,同時維持優異性能表現。

本文介紹了 LLM 中的中間填充 (FIM) 技術,該技術能根據上下文生成缺失的程式碼片段。文章探討了 FIM 的原理、挑戰、應用和未來方向,指出 FIM 將大幅提升程式碼生成和軟體開發的效率,並在塑造 AI coding 未來上扮演重要角色。

這篇文章介紹如何結合大型語言模型(LLM)生成範例 Q&A 的合成資料,並使用 Google App Script 將資料自動化匯入 Google 試算表。透過這樣的自動化流程,使用者能快速建立高效且視覺化的 Q&A 範本,尤其對於需要大量數據管理的情境十分實用。文章詳細說明了使用 LLM 生成範例資料及 Google App Script 自動處理資料的具體步驟,並展示了實際應用的效果。

Large Language Models(LLMs)已成為 AI領域的核心推動力。然而,伴隨著這些進步,LLMs 也帶來了一個令人頭痛的問題:「幻覺」(hallucinations)。這種現象指的是模型在缺乏足夠資訊或理解的情況下,仍然自信地生成錯誤或不準確的內容,誤導使用者。為了應對這一挑戰,Google 推出了 DataGemma,其目標是想要將 LLMs 與龐大且可靠的真實世界數據資料庫『Data Commons』相結合的創新嘗試。

OpenAI 新推出的 o1 系列模型,厲害的地方是可以做很深入的推理。它在科學推理方面表現特別好,像是在程式競賽和數學比賽中都拿到很高的成績。這個模型最特別的是,它會先想一想再回答,而且可以產生很長的內部思考過程。現在有兩種版本:o1-preview 適合需要用到廣泛知識的難題,o1-mini 則比較適合程式和數學任務。不過要注意,用這個模型時要給它足夠的空間來思考喔!

Gemma 是一系列輕量級、先進的開放大語言模型,建立於與創造 Gemini 模型相同的研究和技術之上。由『Google DeepMind』和Google 其他團隊開發,Gemma 靈感來自 Gemini,名字反映了拉丁文 gemma 的意思,即「寶石」。除了模型權重外,Google 也發布了工具來支持開發者創新、促進合作,並指導如何負責任的使用 Gemma 模型。

基本上,在 AWS 上要能夠成功執行起 Llama 2 Chat (7B) #7B而已呦不是70B呦 的 Hello World 沒開個 g5.4xlarge 是跑不起來的,一個月不關機器採用 on-demand 的話要燒掉 37,968.84 TWD,反之用 AWS 的 Bedrock 你開個 Llama 2 Chat(70B)每

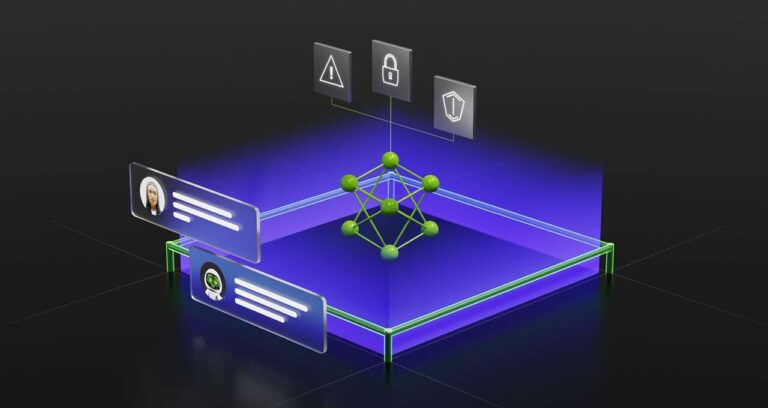

在去年十一月 ChatGPT 出現在我眼前之後,第一個想法就是 LLMs 勢必將會快速的掃除 Chatbot 這樣一個應用領域在過去遇到的許多問題,毫無意外的,聊天機器人現在嚴然是最多開發者實踐 LLMs 的 downstream task。根據 Gartner 的一些報告,他們預期到 2027 年,聊天機器人將成為所有組織中 25% 的主要溝通渠道。 這種採用速度相當驚人,但也存在危險。聊天機器人可以非常有說服力地杜撰事實,而要像對真人一樣給聊天機器人設置指引也更加的困難。所以,如果你客服渠道後面部署了一群真人客服,他們會受過關於如何談論你的公司、不該說什麼、應該說什麼以及要禮貌等各方面的培訓。但對於 LLM-based 的聊天機器人來說在實務上是一件相當困難的事情,實作過你就會清楚的知道開發出一個 ChatGPT 的體驗跟直接與 OpenAI 的 API

-768x432.jpg)

這幾天真的是非常的忙,總算在週末時騰出了些時間來看看 Andrej Karpathy 近期非常火的一段 YouTube,如果說他之前在微軟的活動上所進行的那場 State of GPT 是一場對開發者講述什麼是 LLM 的經典演說的話,那他這一次這段時長一小時的分享影片就是一場面向一般大眾介紹什麼是 LLM 的經典。 一個小時的內容全部都是非技術介紹,涵蓋了 #模型推理、#模型訓練、#模型微調 以及 LLM 的發展趨勢,以及安全挑戰。影片的內容非常的新,基本上還有涵蓋到了近一個月在 LLMs 上的相關發展,有些關於 LLMs 的觀念與知識我也是因為看了這次的分享才知道,同時也釐清了一些我對 LLMs 原本不甚瞭解的地方。 Andrej